¿YouTube le ofrece videos de niños a los pedófilos?

Youtube lleva años acumulando polémicas, pero ésta es realmente grave: el New York Times ha revelado que el sistema de recomendaciones de contenido de la plataforma suministra automáticamente vídeos de menores a grupos de pedófilos. Análisis de Hugo Saéz compartido desde su hilo de Twitter.

La historia es así: En 2006 Youtube fue comprada por Google por 1.650 millones dólares. A pesar de la enorme inversión, Youtube estuvo varios años en constantes pérdidas. Aún así a Google no le importaba, porque la plataforma no paraba de crecer en usuarios. Pero algo comenzó a cambiar a partir de 2010, con la llegada de Salar Kamangar a la dirección de Youtube. Google buscaba tener más control y empezar a rentabilizar la compañía y para ello tenían que cambiar muchas cosas. Youtube necesitaba ingresar más dinero y eso sólo se podía conseguir poniendo más anuncios. Y para poner más anuncios era obligatorio aumentar las horas de visualización de los usuarios. Y aumentarlas MUCHO.

La nueva dirección de Youtube se obsesionó con una cifra: alcanzar las 1.000 millones de horas de vídeos vistas al día. Tras varios años de esfuerzo en 2017 alcanzaron su objetivo, ya con la actual CEO al frente (Susan Wojcicki). Así celebraba la compañía el logro en su blog.

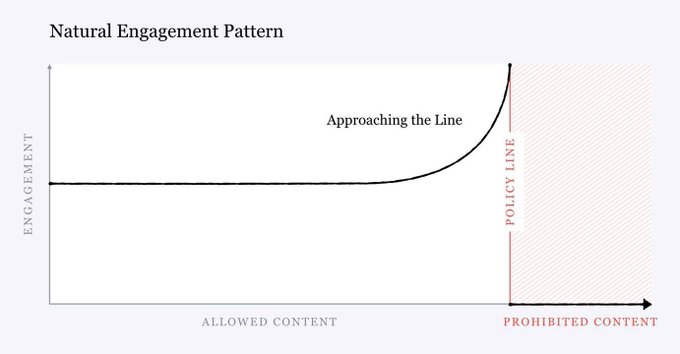

Youtube, al igual que Facebook, descubrió que el contenido que más cerca se encuentra de estar prohibido es el que consigue que pasemos más tiempo en la plataforma. Durante años decidió seguir recomendándolo, tomar el dinero de los anuncios y guardar silencio.

Este enorme aumento de horas de visualización hizo crecer de igual manera los beneficios ya que la cantidad de anuncios emitidos era mucho mayor. En 4 años habían conseguido multiplicar por 4 sus ingresos, lo que podría considerarse un éxito. Pero no es tan así. Para conseguir este enorme aumento de horas vistas al día, Youtube tuvo que modificar por completo la red neuronal de recomendaciones de vídeos para que cumpliese un solo objetivo: conseguir que los usuarios pasasen el máximo tiempo posible en la plataforma.

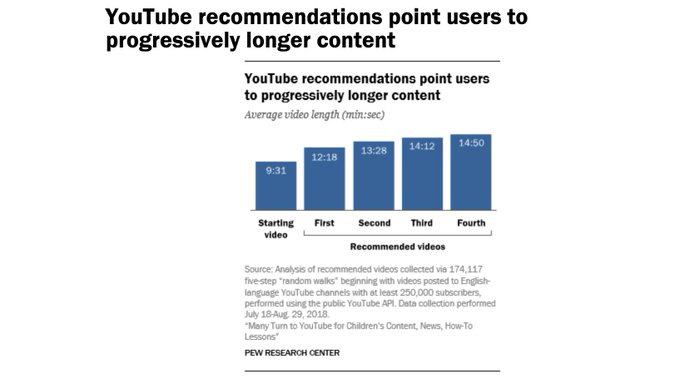

Esta red neuronal aprende poco a poco como conseguir que pasemos cada vez más tiempo consumiendo contenido y, por ejemplo, comienza a recomendar a los usuarios vídeos cada vez más largos (no sólo más afines a sus intereses).

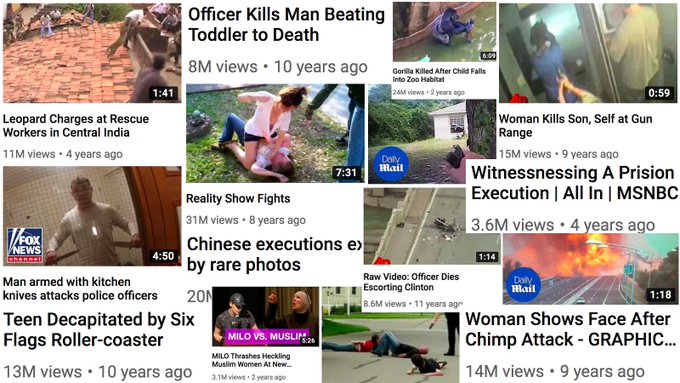

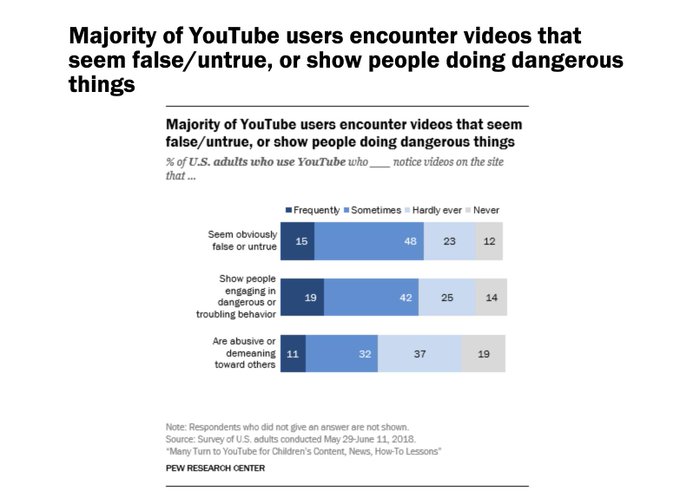

Pero no sólo eso: también aprende que el contenido que nos enfada, el contenido extremo o controvertido engancha a los espectadores a la pantalla. Y empieza a recomendarlo. A recomendarlo constantemente. A muchos usuarios.

Youtube, al igual que Facebook, descubrió que el contenido que más cerca se encuentra de estar prohibido es el que consigue que pasemos más tiempo en la plataforma. Durante años decidió seguir recomendándolo, agarrar el dinero de los anuncios y guardar silencio.

Es entonces cuando los analistas comienzan a darse cuenta de que algo raro ocurre en Youtube. La periodista Zeynep Tufekci descubre que la plataforma, independientemente de lo que estés viendo, cada vez te ofrece contenido más extremo.

Los vídeos de conspiraciones, de ideologías extremas, con mensajes misóginos o de odio hacia minorías comienzan a ser una constante en las recomendaciones de los usuarios y a ganar miles de visitas.

Muchos medios reportan que en Youtube comienza a producirse cada vez más el efecto “madriguera de conejo”: ciclos de contenido que arrastran al espectador a consumir vídeos cada vez más extremos, más peligrosos y más conspiranoicos.

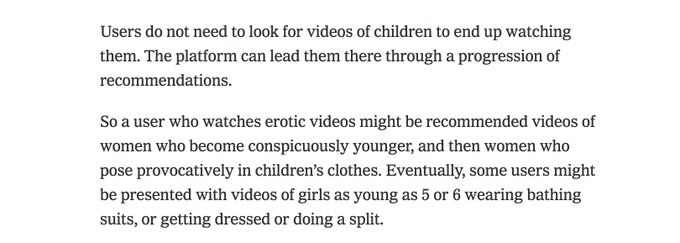

Y finalmente llegamos al escándalo sobre la pedofilia: la red neuronal de Youtube descubrió que existía un público muy concreto que demandaba vídeos de niños pequeños, así que se los suministraba vía recomendación.

El contenido de estos vídeos no era sexual en sí mismo: niños pequeños jugando o hablando a cámara. Pero juntos formaban un patrón de consumo que hacía que un tipo de usuario pasase mucho tiempo en la plataforma, así que la red neuronal de Youtube se lo proporcionaba.

Vídeos inocentes de niños jugando en una piscina alcanzaban la increíble cantidad 400.000 visitas y estaban siendo recomendados a gente que consumía videos eróticos en Youtube. El sistema de recomendaciones solo estaba haciendo su trabajo: aumentar el tiempo de visionado.

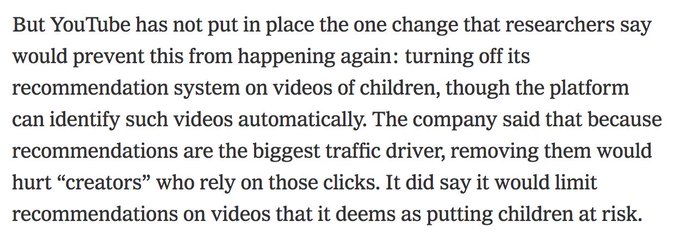

A pesar de la enorme polémica, Youtube no ha eliminado el sistema de recomendaciones: tan sólo lo ha limitado para este tipo de vídeos. La plataforma argumenta que no puede hacerlo desaparecer completamente porque “perjudicaría a los creadores de contenido”.

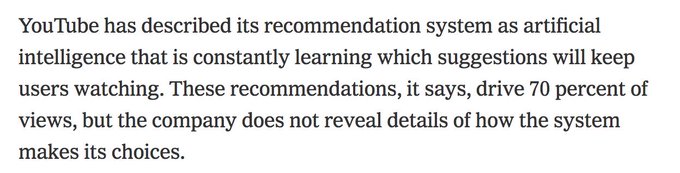

Pero en realidad hay otro motivo más importante: el 70% de las visualizaciones de vídeos en Youtube suceden gracias al sistema de recomendación. Eliminarlo supone renunciar a muchísimos ingresos en forma de anuncios.

Para Youtube acabar con su sistema de recomendaciones de vídeos significaría apagar la máquina de hacer dinero. Y no parece que esté dispuesto a hacerlo incluso aunque se revelen efectos secundarios tan terribles como éstos. En este artículo de hace unos meses Hugo Sáez comentaba algún aspecto sobre esta lucha por nuestra atención y sus consecuencias:

Ésta es la respuesta oficial de Youtube a la crisis, donde propone:

1 – Reducir las recomendaciones de estos vídeos

2 – Restringir el contenido en directo a menores

3 – Prohibir los comentarios en estos videos

El tema de la prohibición de los comentarios es fundamental porque hace unos meses Youtube sufrió otra crisis importante cuando se descubrió que los pedófilos los utilizaban para indicar los momentos clave en vídeos de niños.

A pesar de que Youtube lleva meses trabajando en ello, diferentes análisis de medios han confirmado que los comentarios siguen apareciendo en los vídeos de niños.

Youtube ha defendido muchas veces que el contenido extremo no funciona mejor que el contenido normal. En @Gizmodo se tomaron la molestia de revisar algunos canales y comprobar los vídeos más vistos. El resultado no da la razón a Youtube precisamente:

Se han hecho muchos análisis sobre cómo el contenido extremo siempre acaba apareciendo en los vídeos recomendados de Youtube. Aquí explican como en Alemania aparecían vídeos de ideologías extremas al buscar información sobre una manifestación.

Es curioso que Youtube se escude en los creadores de contenido para no eliminar o modificar el sistema de recomendaciones de vídeos cuando lleva años dando prioridad a las marcas y a los medios tradicionales.

De hecho esa perdida de visitas debido al cambio de foco en Youtube está forzando a los creadores a tener que crear contenido cada vez más polémico para mantenerse y eso lleva a muchos al hartazgo, a quemarse y abandonar la plataforma.

Y no sólo eso, sino que además Youtube está siendo muy agresivo en el tema del copyright con su política de gestión de derechos en favor de las empresas, lo que muchas veces ocasiona que vídeos legales no generen ingresos para sus creadores.

Por no hablar de la presión a la que están sometidos muchos creadores de contenido por su orientación sexual, raza o ideología. El último caso el de Carlos Maza (@gaywonk) que lleva meses siendo acosado y Youtube no ha hecho nada por evitarlo.

Youtube acaba de publicar otro post en su blog a raíz de la crisis, afirmando que va a prohibir el contenido que incite al odio y reducir el contenido que está cerca de estar prohibido. Tras los últimos escándalos ha tenido que reaccionar.

Como suele suceder con Google y Facebook, una cosa es proponer políticas y otra llevarlas a cabo. Youtube ha vuelto a demostrar con el caso de Carlos Maza que no está tan dispuesto a acabar con el «hate speech» como anuncia en su blog.

Los medios digitales y los expertos ya están analizando este nuevo cambio de políticas y no son muy clementes con Youtube: “The platforms have become very good at issuing PR statements about proposed changes that don’t ultimately have much effect.»

El medio @voxdotcom ha hecho un artículo muy interesante recopilando todo el caso de Carlos Maza, incluyendo las respuestas que Youtube le ha ido según avanzaba la polémica. Por otro lado los anunciantes no han reaccionado a la polémica y esa es una de las claves de la situación. En este artículo de Adweek se explica muy bien: «Mientras no se les acuse públicamente de ser parte del problema, no van a hacer nada»

Este artículo de hace un par de meses de @verge resume bien la situación actual de Youtube para los creadores de contenido: la era dorada ha terminado:

Una de las medidas que puede conseguir que muchas de estas políticas cambien es la acción del gobierno estadounidense. La presión aumenta sobre Google y puede que eso les incentive para cambiar antes de que sea tarde. Gran reportaje del @nytimes sobre la radicalización en Youtube, como funciona y porqué ha sucedido, siguiendo el caso concreto de un joven que cayó en la madriguera de conejo de la plataforma.

La CEO de Youtube, Susan Wojcicki, ha concedido una entrevista a @Recode en la que habla acerca de las diferentes polémicas que ha sufrido la plataforma últimamente, entre muchos otros temas. La puedes escuchar aquí. En @verge se centran en sus disculpas tras las últimas decisiones sobre el caso de Carlos Maza. Según Wojcicki los vídeos no infringían las normas de Youtube porque «The context of the video really, really matters,»

Interesante artículo de @business que analiza Youtube Kids, su poco éxito y el miedo de los padres a Youtube. «4 people at Google privately admitted that they don’t let their kids watch YouTube unsupervised.»

El gobierno de Estados Unidos está investigando a Youtube por sus problemas para gestionar el contenido de menores de edad y la protección de éstos ante posibles delitos. Interesante artículo en @el_pais sobre las recomendaciones de Youtube y sus implicaciones en España.

Este artículo en Medium explica bastante bien como los bandazos de Youtube en torno a las políticas de moderación de contenido están perjudicando a los creadores, que ven sus contenidos censurados sin poder hacer mucho al respecto.

El @nytimes hace un perfil interesante de la CEO de Youtube Susan Wojcicki y habla sobre cómo ha intentado afrontar todos los problemas que tiene la plataforma.

Guillaume Chaslot (@gchaslot) trabajó en la creación de la IA de recomendación de vídeos de Youtube. Hace unos días publicó un artículo muy interesante en Wired sobre sus peligros, que conoce de primera mano.

El @nytimes sigue explorando las consecuencias del algoritmo de recomendaciones de Youtube. Esta vez cuenta como la plataforma ayudó a radicalizar Brasil y analiza su influencia en la elección de Bolsonaro como presidente.

Éste extracto del artículo resume bien el problema: «Crucially, users who watched one far-right channel would often be shown many more. The algorithm had united once-marginal channels — and then built an audience for them, the researchers concluded.» Este artículo del @washingtonpost revela que los moderadores de Youtube no pueden borrar vídeos, solo desmonetizarlos. De esta manera su difusión no se detiene, algo problemático para los vídeos polémicos.

El problema está lejos de resolverse todavía. Para mantenerse al corriente, se puede visitar el hilo de discusión aquí.

Hugo Sáez habla sobre publicidad, digital y behavioral science. Historias y análisis sobre el comportamiento humano y su influencia en el mundo digital, en el marketing y en la comunicación. Aquí puedes leer sus hilos.